Війна в Україні

СУМАРНІ ОРІЄНТОВНІ ВТРАТИ ПРОТИВНИКА НА 1459 ДЕНЬ.

TEREN - напиши

Зараз слухають і кайфують - прем'єра кліпу

«Напиши» - це інтимний діалог з тими, хто залишився на самоті з величезною відстанню до тих, кого вони люблять. Чуттєва та влучна історія про підтримку, близькість і силу простих слів у складні часи, коли вас розділяють кілометри, кордони та різні світи.

Яке місце Україна посяде на Євробаченні

Від нашої країни їде співачка Leleka

Що слухає Україна

10 найпопулярніших пісень за даними Apple Music

Курс валют на сьогодні

Ціни на пальне у мережевих АЗС України

ТОП-5 НАЙБАГАТШИХ МЕРІВ УКРАЇНИ - ДАНІ З ДЕКЛАРАЦІЙ (млн. грн.)

ТОП-7 найдорожчих брендів світу за версією VisualCapitalist

ТОП-5 ПОЛІТИКІВ УКРАЇНИ З НАЙВИЩИМ РЕЙТИНГОМ

За опитуванням SOCIS 21 січня 2025

Актуальний курс кріптовалют

ПʼЯТІРКА НАЙБАГАТШИХ ЛЮДЕЙ СВІТУ

за версією Bloomberg

Як Ігор Рець вижив на стежці ухилянтів із Закарпаття в Румунію

Кореспондент Інформатора забрався на високогір'я Карпат і прожив тиждень у притулку для туристів, щоби взяти інтерв'ю у ухилянтів; на шляху він зустрів прикордонників, військкомів із Хуста, а також численні порушення закону

ТОП-10 найпотужніших економік світу

За даними Світового банку

Підпал авто ЗСУ

Кому саме спецслужби РФ через ресурси з працевлаштування пропонують легкі гроші за злочин против оборони держави: розслідування Інформатора

Кулінарний рецепт від Інформатора

Актор Стенлі Туччі виявив головну слабкість Северуса Снейпа - майже зіллєваріння

Дослідження: штучний інтелект ChatGPT может створювати біологічну зброю

GPT-4 несе ризик створення біологічної зброї через потужний штучний інтелект

Найпотужніший штучний інтелект, GPT-4, який навчився брехати керівництву, коли навчився торгувати на біржі, може стати інструментом допомоги людям у створенні біологічної зброї. Хоча ризик є невеликим, відкриття є відправною точкою для продовження досліджень і професійного обговорення проблеми. Такі результати досліджень були виявлені провідними спеціалістами OpenAI.

Як повідомляє Bloomberg, перші тести, які компанія провела для розуміння та запобігання можливій "катастрофічній" шкоді від своєї технології, показують, що GPT-4 може представляти "щонайбільше" невеликий ризик у створенні біологічних загроз. Зокрема, в статті зазначається, що програма може полегшити завдання зловмисникам у розробці біологічної зброї, використовуючи чатботи для пошуку інформації про планування атак.

Відзначається, що протягом останніх місяців політики та експерти висловлювали обурення стосовно можливості використання ШІ для цієї мети. OpenAI реагує на ці збурення, створюючи команду, яка спрямована на мінімізацію ризиків від ШІ. За результатами першого дослідження залучено 50 експертів з біології та 50 студентів для вивчення можливостей створення біологічних загроз з використанням GPT-4.

Порівнюючи групи, які використовували мовну модель GPT-4 та тільки інтернет, дослідники виявили певне підвищення точності та повноти для першої групи. Вони прийшли до висновку, що доступ до GPT-4 забезпечує помірне підвищення ймовірності отримання інформації для створення біологічної загрози.

Bloomberg підкреслює, що це лише одне з численних досліджень, проведених OpenAI, з метою розуміння можливого зловживання GPT-4. Інші напрямки включають вивчення потенціалу для створення кіберзагроз та як інструменту впливу на людей для зміни їхніх переконань.

Що ChatGPT каже про війну

ChatGPT (саме користувачі цього сервісу можуть користуватися GPT-4), чия інформація була актуальна лише до початку 2021 року, не повірив у ймовірність наступу рф до 2022 року та назвав Україну "добре підготовленою" до військового конфлікту. Варто зазначити, що ChatGPT намагається максимально обходити слово "війна", замінюючи його на нейтральний "конфлікт".

ChatGPT назвав "політичні, економічні та геостратегічні інтереси росії в регіоні, а також внутрішні політичні обставини в країні". Окрім того, у використанні військової агресії він побачив "засіб збільшення популярності у виборчих кампаніях". Що стосується "захоплення Києва за три дні" ШІ назвав це "вкрай складним та ризикованим процесом".

Нагадаємо, що штучний інтелект навчили передбачати час смерті людини: прогнози справджуються у 75% випадків. Фактори, які означають більш ранню смерть: чоловіча стать, психічні розлади, робота висококваліфікованим спеціалістом.

Підписуйтесь на наш Telegram-канал, щоб не пропустити важливих новин. За новинами в режимі онлайн прямо в месенджері слідкуйте на нашому Telegram-каналі Інформатор Live. Підписатися на канал у Viber можна тут.

ЧИТАЙТЕ ТАКОЖ:

Останні новини

Гороскоп на 22 лютого: день обіймів, смаку та спокою

Двоповерховий автобус і вантажівка зіткнулися під Кропивницьким: загинули двоє водіїв

Росія готує новий масований удар по Україні вже вночі 22 лютого: у хід підуть авіація, ракети та сотні дронів - моніторингові канали

Сирський вперше з початку війни назвав головну перемогу України у 2025 році

Стрілянина та побиття військових Айдару на Дніпропетровщині: серед підозрюваних - боєць у СЗЧ

Орбан слідом за Фіцо пригрозив залишити Україну без світла: під ударом майже половина імпорту

Українця у США засудили за продаж персональних даних КНДР: 5 років тюрми та мільйонні конфіскації

Дональд Трамп підвищує глобальні мита до 15% і готує нові тарифні обмеження

Україна не стане перепоною для миру - Зеленський з Умєровим налаштувались на змістовний раунд переговорів

В Молдові відмінили помилування для злочинця, який готував гучні вбивства в Україні

Справжній лебединий рай: на Оболоні зібралися десятки птахів

Як новенька: в Бучі відновили хрущовку, в яку влучили артилерією на початку 2022 року

Популярне

Гороскоп на 22 лютого: день обіймів, смаку та спокою

Найкращий момент для відновлення та відпочинку: хочеться комфорту, краси та простих радощів - астропрогноз на неділю для всіх знаків ЗодіакуСирський вперше з початку війни назвав головну перемогу України у 2025 році

2025 рік став переломним у війні. Вперше втрати російської армії перевищили кількість новобранців, зазначає головнокомандувач ЗСУ Олександр Сирський. Українські війська щодня виводять з ладу понад тисячу противників і повертають контроль над втраченими територіями

Зима ще спробує нашкодити Україні – прогноз погоди на 22 лютого

Відчутним потепління стане у понеділок, а поки ще трохи доведеться потерпіти зимовий характер погоди

Завершення тимчасового захисту для українських біженців за кордоном: хто залишиться та як допоможуть тим, хто повернеться

Держави-члени ЄС заявляють, що вони хотіли б і надалі підтримувати українцівБезпрецедентний удар по монархії: Британія готує закон про виключення Ендрю з лінії престолонаслідування

Уряд Великої Британії розглядає радикальні зміни в законодавстві, які назавжди позбавлять Ендрю Маунтбеттен-Віндзора навіть примарного шансу на коронуВійськовий оглядач

Двоповерховий автобус і вантажівка зіткнулися під Кропивницьким: загинули двоє водіїв

Сирський вперше з початку війни назвав головну перемогу України у 2025 році

Стрілянина та побиття військових Айдару на Дніпропетровщині: серед підозрюваних - боєць у СЗЧ

Добрі новини

Оформити відстрочку через Резерв+: адвокат про можливості, обмеження та типові проблеми

Грамотний підхід і своєчасні дії дозволяють або успішно оформити відстрочку через Резерв+, або вибудувати правильну стратегію, все одно її отримати через ЦНАП або через суд — без паніки і зайвих ризиківТаксі у комендантську годину: Bolt відновлює цілодобову роботу в Дніпрі та інших містах України

Поїзд «Одеса – Дніпро» курсуватиме щодня: «Укрзалізниця» збільшує кількість рейсів через негоду

Ожеледиця та снігопад: як виглядає Дніпро під час хурделиці

Залужний: воєнний стан потрібно було ввести у січні 2022 року, але Зеленський не хотів - The Guardian

За словами ексголовкома, запровадження воєнного стану дозволило б перегрупувати війська, підготувати плани оборони та краще організувати реагування на загрозуПолітичний оглядач

Росіяни готують нові удари по енергетиці - Шмигаль

САП подала позов на екскерівника підрозділу детективів БЕБ: необґрунтовано придбав автівки на 4 млн грн

У Словаччині українець попався на крадіжці круасанів: виявилось, його розшукує Інтерпол

Новини столиці

Справжній лебединий рай: на Оболоні зібралися десятки птахів

Як новенька: в Бучі відновили хрущовку, в яку влучили артилерією на початку 2022 року

Зачепило: киянин цілий день воював з міськими службами, щоб евакуатор вивіз авто-порушника

Стадіон Динамо геть полисів: з причин - зимова негода та, ймовірно, байдуже ставлення

У Голосієві згоріла приватна садиба, вогонь забрав життя двох людей

Кореспондент проєкту "Гроші"

Завершення тимчасового захисту для українських біженців за кордоном: хто залишиться та як допоможуть тим, хто повернеться

Шахраї продали одну машину двічі — дніпрянка втратила 105 982 гривень: що вирішив суд

Жінка платить за абонементну скриньку в Укрпошті, але годинами стоїть у черзі за листами - реакція компанії

Економіка та фінанси: останні новини

Подарунки у 2026 році: юрист пояснив, коли треба платити податки

BTC, ETH, золото та срібло: Кійосакі прогнозує найбільший крах фондового ринку в історії

Оформити відстрочку через Резерв+: адвокат про можливості, обмеження та типові проблеми

Жінка платить за абонементну скриньку в Укрпошті, але годинами стоїть у черзі за листами - реакція компанії

Чоловік вломився в службове приміщення Укрзалізниці, виламував двері та кидав каміння — суд виніс вирок

Економічний оглядач Інформатора

Кохання, любов, купідон у назвах українських компаній: дослідження YouControl

Справи 35 нардепів у Вищому антикорупційному суді: декларування, хабарі, збагачення

Щоб ваш Starlink і надалі працював - зареєструйте його у ЦНАПі: корисні поради

808 тисяч зарплати, будинок у Козині, старий мопед, квартира у довгобуді: декларація голови ФДМУ Наталухи за 2025 рік

Від Порошенка до Зеленського: карколомна кар'єра нового очільника ФДМУ Наталухи

Новини шоу-бізнеса

Зірка Кварталу так дістав дружину, що вона не витримала: Потрібна була відстань один від одного

Дружина Юрія Ткача зізналася, чому вони опинилися на межі розлучення

Я поважаю свого президента: зірка серіалу Пес виявився жертвою пропаганди

Актор Михайло Жонін згадав, що казав йому на початку повномасштабного вторгнення Микита Панфілов

Бубка догрався – через Гераскевича його можуть позбавити звання Героя України

Український скелетоніст Владислав Гераскевич розповів про бізнес родини Бубки з окупантами та втечу спортсмена з України

Помер 53-річний Ерік Дейн: зірка «Анатомії Грей» не подолав важку хворобу

Причиною смерті зірки «Ейфорії» став бічний аміотрофічний склероз, про який актор заявив у 2025 році

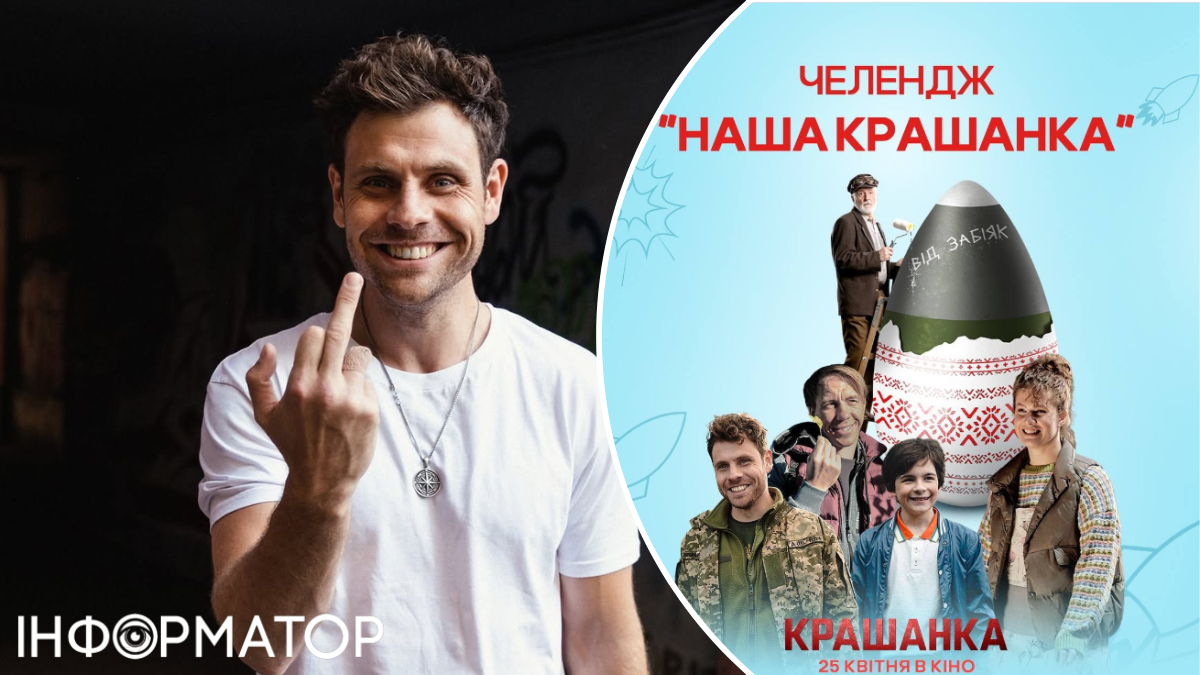

Росіяни споганили фільм зі Станіславом Бокланом, зробивши з нього Адское яйцо

Актор Артур Логай здивував новиною про крадіжку росіянами українських комедій, а також поділився секретами шоу ЗрадникиКореспондент проєкту "Зірки"

Зірка Кварталу так дістав дружину, що вона не витримала: Потрібна була відстань один від одного

Я поважаю свого президента: зірка серіалу Пес виявився жертвою пропаганди

Бубка догрався – через Гераскевича його можуть позбавити звання Героя України

Про життя

Гороскоп на 22 лютого: день обіймів, смаку та спокою

Зима ще спробує нашкодити Україні – прогноз погоди на 22 лютого

Три знаки Зодіаку, яким 23 лютого – 1 березня особливо пощастить у коханні

Помилки, які псують курку при запіканні: почнемо з правильної ваги

Актор Стенлі Туччі виявив головну слабкість Северуса Снейпа - майже зіллєваріння

Новини Дніпра