Війна в Україні

СУМАРНІ ОРІЄНТОВНІ ВТРАТИ ПРОТИВНИКА НА 1465 ДЕНЬ.

VOLODYMYR DANTES - просто кохаю

Зараз слухають і кайфують - прем'єра кліпу

Моя нова пісня «просто кохаю» про бажання бути разом у дрібницях: писати вірші, дарувати пісні, цілувати “просто так”, обирати людину щодня не тому, що треба, а тому, що хочеться бути з нею. Просто бути поруч, просто кохати.

Яке місце Україна посяде на Євробаченні

Від нашої країни їде співачка Leleka

Що слухає Україна

10 найпопулярніших пісень за даними Apple Music

Курс валют на сьогодні

Ціни на пальне у мережевих АЗС України

ТОП-5 НАЙБАГАТШИХ МЕРІВ УКРАЇНИ - ДАНІ З ДЕКЛАРАЦІЙ (млн. грн.)

ТОП-7 найдорожчих брендів світу за версією VisualCapitalist

ТОП-5 ПОЛІТИКІВ УКРАЇНИ З НАЙВИЩИМ РЕЙТИНГОМ

За опитуванням SOCIS 21 січня 2025

Актуальний курс кріптовалют

ПʼЯТІРКА НАЙБАГАТШИХ ЛЮДЕЙ СВІТУ

за версією Bloomberg

Як Ігор Рець вижив на стежці ухилянтів із Закарпаття в Румунію

Кореспондент Інформатора забрався на високогір'я Карпат і прожив тиждень у притулку для туристів, щоби взяти інтерв'ю у ухилянтів; на шляху він зустрів прикордонників, військкомів із Хуста, а також численні порушення закону

ТОП-10 найпотужніших економік світу

За даними Світового банку

Підпал авто ЗСУ

Кому саме спецслужби РФ через ресурси з працевлаштування пропонують легкі гроші за злочин против оборони держави: розслідування Інформатора

Кулінарний рецепт від Інформатора

Примхлива Елізабет Тейлор зажадала надіслати літак за своїм улюбленим обідом - рецепт

"Можлива втрата контролю над цивілізацією". Ілон Маск та тисяча науковців просять призупинити роботу над ШІ

Штучний інтелект може стати загрозою цивілізації, тому потрібно обережно підходити до його навчання

Понад тисяча науковців на чолі з мультимільярдером Ілоном Маском та співзасновником Apple Стівом Возняком підписали відкритого листа у якому закликають припинити розробку просунутого штучного інтелекту. Йдеться в першу чергу про системи, потужніші від GPT-4. На думку науковців, штучний інтелект може становити для людства екзистенційну загрозу й потрібно обережно підходити до його розробки та вивчення.

Листа опублікували на сайті Інституту майбутнього життя (Future of Life Institute). Автори закликали негайно призупинити навчання потужних систем штучного інтелекту. Експерти переконані, що не можна проводити подальше навчання систем, доки не з’являться загальні протоколи безпеки. На їхню думку, якщо це не зроблять розробники, влада повинна накласти мораторій законодавчим рішенням.

У чому причина

Автори листа вважають, що зараз людство, у тому числі й розробники, не можуть контролювати штучний інтелект. Водночас сучасні системи штучного інтелекту вже починають конкурувати з людиною.

«… і ми повинні запитати себе: чи маємо ми дозволити машинам заповнювати наші інформаційні канали пропагандою та неправдою? Чи слід автоматизувати всі роботи, включно з тими, які виконують завдання? Чи повинні ми розвивати нелюдські уми, які із часом можуть перевершити, перехитрити, зробити нас застарілими та замінити нас? Чи варто ризикувати втратою контролю над нашою цивілізацією? Такі рішення не можна делегувати невибраним технічним керівникам. Потужні системи штучного інтелекту слід розробляти лише тоді, коли ми будемо впевнені, що їхній ефект буде позитивним, а ризики — керованими» — йдеться в листі.

Підписанти не вважають, що потрібно взагалі відмовитися від розробки ШІ. Йдеться лише про паузу для вивчення та аналізу ситуації.

У чому небезпека ШІ

Штучний інтелект — це не добре й не погано. Це як скальпель: можна зробити операцію на серці, а можна вбити. Але технологія розвивається вражаючими темпами й людство не встигає адаптуватися, вивчити всі можливі небезпеки та запобігти негативним наслідкам. ШІ може бути небезпечним із багатьох причин:

- Може замінити людей. Штучний інтелект може виконувати обчислення та аналізувати дані значно швидше, ніж людина. Він вчиться миттєво, тому незабаром може скластися ситуація, коли сотні мільйонів людей виявляться непотрібними на ринку праці. А ще сотні мільйонів будуть потрібні лише для того, щоб стирати з комп’ютерів пилюку.

- Недостатньо вивчений. Якщо система штучного інтелекту не допрацьована чи не протестована на всі можливі сценарії, це може привести до помилок та неправильних висновків.

- Не вміє реагувати на непередбачувані випадки. Штучний інтелект може використовуватися для розв’язання дуже складних задач, наприклад, в області медицини чи як автопілот транспортних засобів. Але система не може передбачити, наприклад, що від вантажівки, на зустрічній смузі руху відвалиться колесо й покотиться прямо на вас. Подібні випадки можуть призвести до небезпеки для життя та здоров’я людей.

- Може бути використаний для зловживання. Штучний інтелект може бути використаний для злочинів, наприклад, для збирання конфіденційної інформації або для здійснення кібератак.

- Тотальний контроль. Уявіть, що авторитарний режим отримав доступ до технології, яка вміє визначати за тим, що Ви переглядаєте в інтернеті, ваше ставлення до влади. Та ще і пропонує силовикам, варіанти того, як найкраще Вас зламати.

Водночас подібні страхи завжди виникали, коли з’являлася якась нова технологія. Історія свідчить, що після винайдення, наприклад, комбайну, селяни не залишилися без роботи.

Ми писали про те, що Мінцифри планує додати ChatGPT у Дію. А ще ми розповідали, що Microsoft планує вбудувати ШІ у свої офісні програми.

Підписуйтесь на наш Telegram-канал, щоб не пропустити важливих новин. За новинами в режимі онлайн прямо в месенджері слідкуйте на нашому Telegram-каналі Інформатор Live. Підписатися на канал у Viber можна тут.

Останні новини

Зеленський заявив, що із задоволенням прийняв би ядерну зброю від Британії та Франції

Фіцо прокоментував розмову з Зеленським: у нас різне бачення щодо "Дружби"

Мотив - гроші: поліція Італії за підозрою у вбивстві українського банкіра затримала його сина

В ГУР показали істерику командирів РФ: через відмову від штурмів погрожують розправою особовому складу

Наймасштабніша ракетна небезпека в тилу РФ: під прицілом «Фламінго» опинилися 13 регіонів

Знищення мережі наведення Шахедів в Білорусі: Федоров та його радник Флеш розкрили деталі

Блокування тіньового флоту: Федоров знайшов больову точку в економічній війні з РФ

Експрем'єр Британії Сунак став радником Зеленського: чим займатиметься

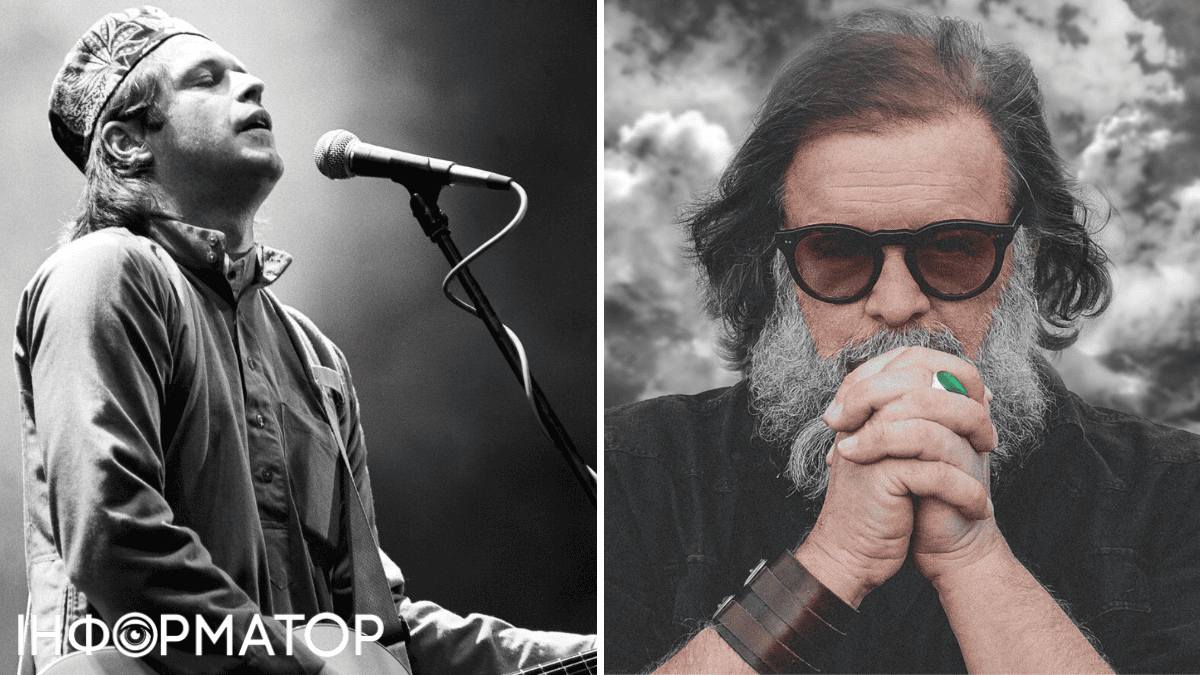

Помер спокійно: у хорошого руського Бориса Гребенщикова в Японії зупинилося серце

«Дарницький» схематоз: чи варто чекати на «Загорійгейт»?

Готель для друзів Путіна: люксовий холдинг Бернара Арно продовжує працювати для еліти Петербурга попри санкції - Reuters

Пропагандистська вистава: в МЗС відреагували на марш "курських ветеранів" у КНДР

Популярне

Зеленський заявив, що із задоволенням прийняв би ядерну зброю від Британії та Франції

Водночас президент наголосив: пропозицій щодо ядерки від партнерів не надходилоПомер спокійно: у хорошого руського Бориса Гребенщикова в Японії зупинилося серце

Співак пояснив, чому смерть це прекрасне відчуття і як вона змінила теперішнє його життя

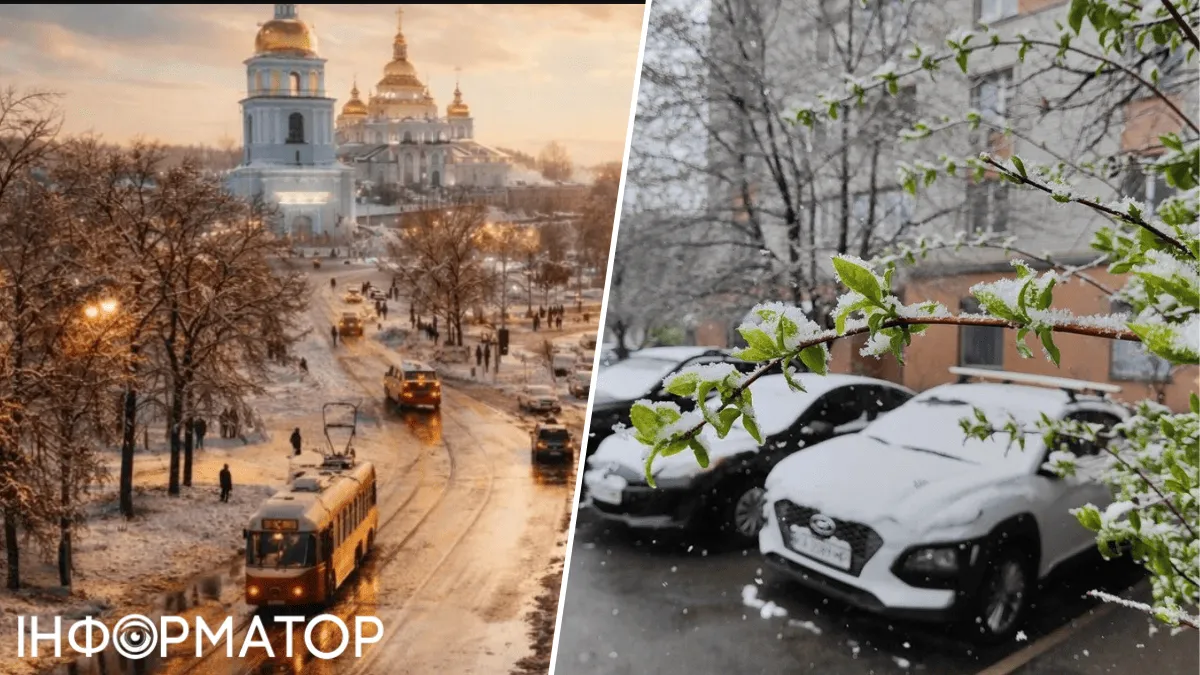

Чи буде останній день зими дійсно останнім – прогноз погоди на 28 лютого

Погода хоч і капризна, але втрималась від неприємних сюрпризів в останній день зими

Нарешті! UPG орендує 65 АЗС, що належали групі «Приват» на Дніпропетровщині

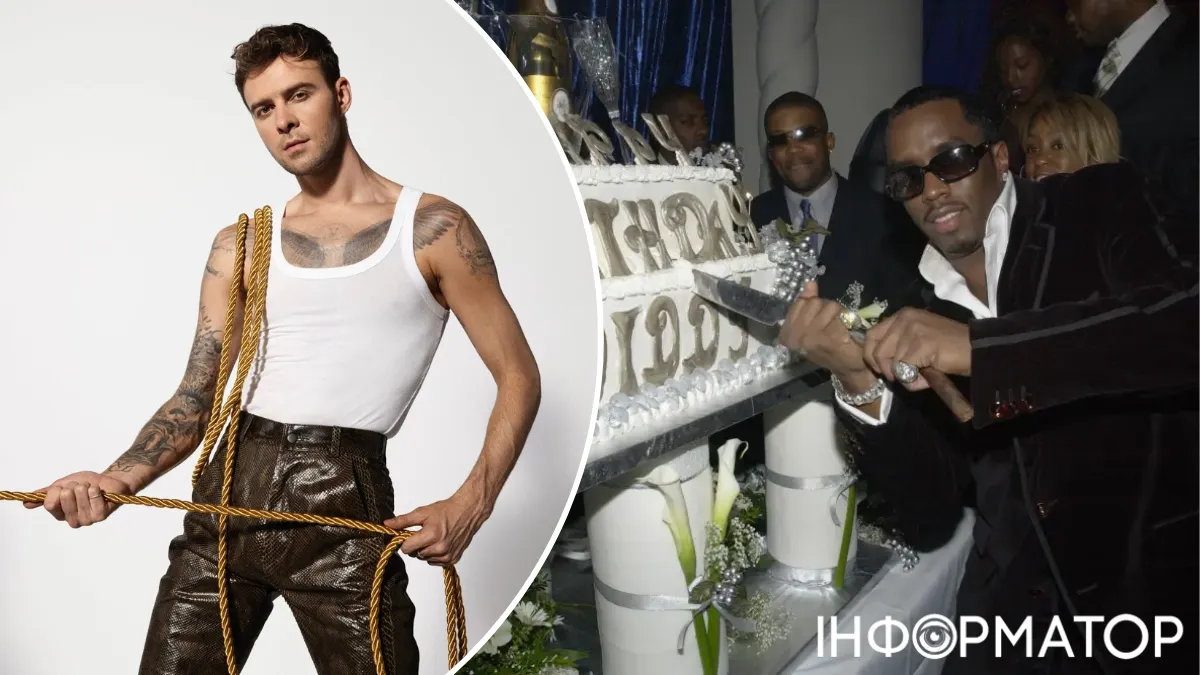

Після цього мережа UPG зросте до 621 станціїМакс Барських розбазікав – у США він їздив на вечірку розпусника P. Diddy

Зірка української поп-музики був запрошений на одну з вечірок голлівудського монстра і мафіозі у світі музикиВійськовий оглядач

Грузія звинуватила Зеленського у невдячності: Стефанчук нагадав про базовий мінімум

Трамп і Зеленський розраховують завершити війну найближчими місяцями - джерела ЗМІ

ЗСУ вдарили по РЛС у Джанкої та командному пункту РФ: підтверджено ураження

Добрі новини

Нарешті! UPG орендує 65 АЗС, що належали групі «Приват» на Дніпропетровщині

Після цього мережа UPG зросте до 621 станціїАМКУ порадив 90 торговим мережам знизити ціни на цукор

Комітет зазначив, що починаючи з квітня 2025 року виробники цукру знижували ціни на власну продукцію, в той же час на полицях магазинів ціни на цей товар синхронно не знижувались у повній міріШколярами-прогульниками займеться поліція: рішення Уряду

Уряд посилив порядок обліку дітей та запровадив оперативний міжвідомчий обмін даними про невідвідування навчанняКабмін змінив правила програми СвітлоДІМ: як ОСББ може отримати гроші на енергоефективність

Розмір державної допомоги становитиме від 100 до 300 тисяч гривень – залежно від поверховості будинку та кількості під’їздів

Перевіряйте картки: Нацкешбек за грудень уже в дорозі

699 млн грн Національного кешбеку переводять на рахунки українцівПолітичний оглядач

Зеленський заявив, що із задоволенням прийняв би ядерну зброю від Британії та Франції

Мотив - гроші: поліція Італії за підозрою у вбивстві українського банкіра затримала його сина

В ГУР показали істерику командирів РФ: через відмову від штурмів погрожують розправою особовому складу

Новини столиці

Маленький червоний корпус: у Києві продають перлину конструктивізму 1930-х років

Колишня Кличка показала, яким кумедним фото її привітала дочка з днем народження

В уряді відповіли, чому досі ніхто не почав ремонт Дарницької ТЕЦ

Київрада може відмовитись від нового будівництва та ремонтів доріг заради підготовки до зими

Слідом за відьмою на кригу пішла тренерка-фігуристка: Київське море манить і губить

Кореспондент проєкту "Гроші"

«Платіть за зв’язок, якого немає по 18–20 годин» — абонент розніс Київстар за підвищення тарифу та знущання з пенсіонерів

12 тисяч гривень кредитних коштів зникли з рахунків Ощадбанку, клієнтка вимагає повернення: яким було рішення суду

Держава нарахувала допомогу одинокій матері автоматично, а потім вимагала повернути 1 811 гривень: що сказав суд

Економіка та фінанси: останні новини

АМКУ порадив 90 торговим мережам знизити ціни на цукор

Оновлений графік обмежень: шахраї шлють небезпечні листи від імені Укренерго

Діти ридають: в МОН назвали дати весняних і літніх канікул

У День протидії булінгу Мін’юст нагадав про відповідальність за цькування, та сказав, де шукати допомогу

Школярами-прогульниками займеться поліція: рішення Уряду

Економічний оглядач Інформатора

Укрзалізниця витратить 15 млн грн на SMS-повідомлення: гроші освоїть фірма з Києва

В Укрпошті відповіли Інформатору, чи використовують вони працю коней, віслюків і лам

У Держпродспоживслужбі проводять перевірку скандальної реклами Укрпошти: відповідь Інформатору

Українці розкритикували додаток 112 від МВС за 3 млн грн: Інформатор знає, що можна покращити

Кохання, любов, купідон у назвах українських компаній: дослідження YouControl

Новини шоу-бізнеса

Помер спокійно: у хорошого руського Бориса Гребенщикова в Японії зупинилося серце

Співак пояснив, чому смерть це прекрасне відчуття і як вона змінила теперішнє його життя

Макс Барських розбазікав – у США він їздив на вечірку розпусника P. Diddy

Зірка української поп-музики був запрошений на одну з вечірок голлівудського монстра і мафіозі у світі музики

Наталка Денисенко вийшла з коханим у світ і не витримала: Залиште нас у спокої

У нових стосунках акторка постійно створює ідилію, тому закликала хейтерів відчипитися від неї

Андрій Данилко зробив вчинок і потрапив у кіно про війну: Я знала, що він не подивиться фільм

Катя Царик розповіла про тривалі робочі стосунки з артистом та про деякі його звички

Андрій Хливнюк поставив діагноз мобілізації: Мене дратує бути жебраком

Лідер гурту Бумбокс згадав свій перший бій та розповів, яких людей він не хоче бачити у своєму підрозділіКореспондент проєкту "Зірки"

Помер спокійно: у хорошого руського Бориса Гребенщикова в Японії зупинилося серце

Наталка Денисенко вийшла з коханим у світ і не витримала: Залиште нас у спокої

Андрій Хливнюк поставив діагноз мобілізації: Мене дратує бути жебраком

Про життя

Чи буде останній день зими дійсно останнім – прогноз погоди на 28 лютого

Медична таємниця: чому ніхто ніколи не чув про рак серця

П'ять класичних ліків, які виявилися занадто підлими – на них навіть не потрібен рецепт

Класичної весни з м’яким переходом не чекайте – прогноз синоптиків на три місяця

Про це блогери не кажуть, бо для них головне – естетичність контенту: наїзд на TikTok

Кореспондент проєкту "Про життя"

Чи буде останній день зими дійсно останнім – прогноз погоди на 28 лютого

Медична таємниця: чому ніхто ніколи не чув про рак серця

П'ять класичних ліків, які виявилися занадто підлими – на них навіть не потрібен рецепт

Новини Дніпра