Война в Украине

СУМАРНІ ОРІЄНТОВНІ ВТРАТИ ПРОТИВНИКА НА 1463 ДЕНЬ.

DOVI & alyona alyona - Виринали

Сейчас слушают и кайфуют - премьера клипа

Сочетание вокалов DOVI и alyona alyona создает эмоциональный диалог об устойчивости и вере в себя. Видеоработа усиливает главный месседж трека – даже после самых глубоких погружений мы способны подняться.

Какое место Украина займет на Евровидении

От нашей страны едет певица Leleka

Что слушает Украина

10 самых популярных песен по версии Apple Music

Курс валют на сегодня

Цены на топливо в сетевых АЗС Украины

ТОП-5 САМЫХ БОГАТЫХ МЭРОВ - ДАННЫЕ ИЗ ДЕКЛАРАЦИЙ (млн. грн.)

ТОП-7 самых дорогих брендов мира по версии VisualCapitalist

ТОП-5 ПОЛИТИКОВ УКРАИНЫ С НАИВЫСШИМ РЕЙТИНГМ

По опросу SOCIS 21 января 2025 года

Актуальный курс криптовалют

ПЯТЕРКА САМЫХ БОГАТЫХ В МИРЕ

По версии Bloomberg

Как Игорь Рец выжил на тропе ухилянтов из Закарпатья в Румынию

Корреспондент Информатора забрался на высокогорье Карпат и провел неделю в убежище для туристов, чтобы взять интервью у ухилянтов; на своем пути он встретил пограничников, а также столкнулся с многочисленными нарушениями закона

ТОП-10 самых мощных экономик мира

По данным Всемирного банка

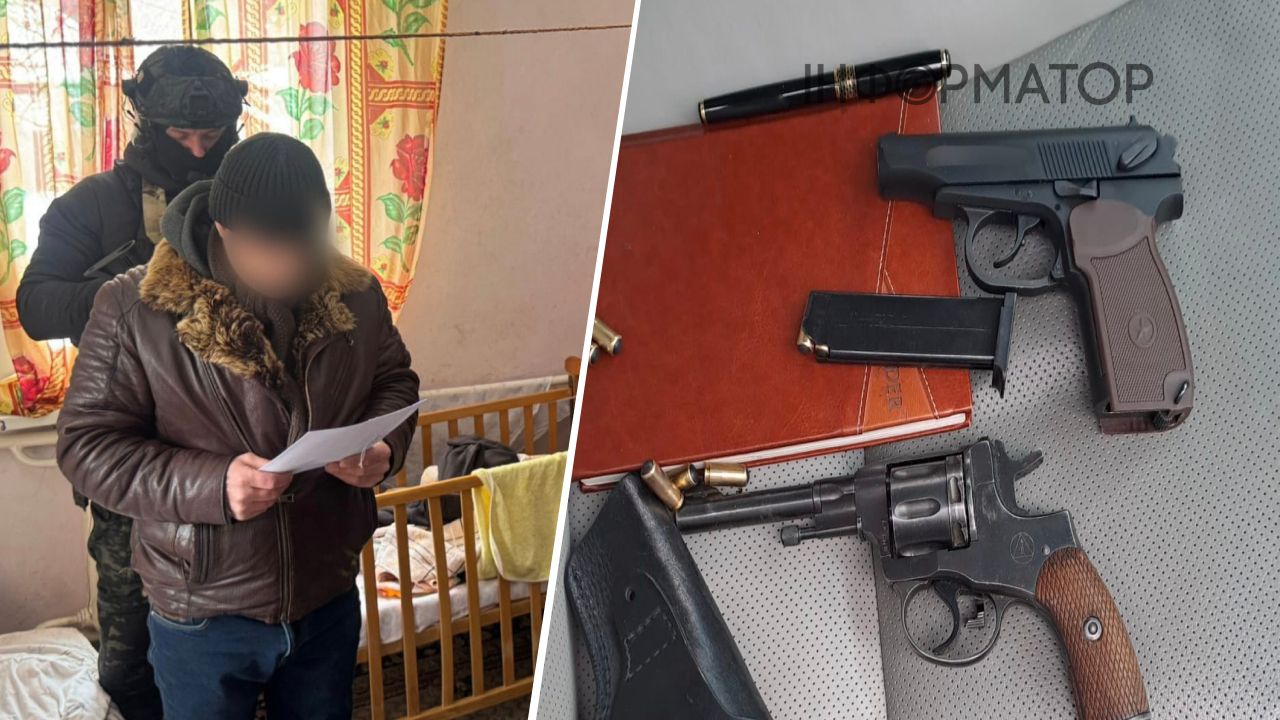

Поджег авто ЗСУ

Кому именно спецслужбы РФ через ресурсы по трудоустройству предлагают легкие деньги за преступление против обороны страны: расследование Информатора

Mastercard внедряет ИИ для выявления подозрительных транзакций

Mastercard инвестировала более $ 7 млрд в развитие кибербезопасности и искусственного интеллекта

Корпорация Mastercard разработала новую модель генеративного искусственного интеллекта Decision Intelligence Pro. Его целью является повышение эффективности в отслеживании мошеннических транзакций среди тысяч банков в своей сети. Технологию запатентовали и скоро будут использовать.

Об этом сообщает CNBC. По информации издания, технологию разработали команды корпорации по кибербезопасности.

Известно, что Decision Intelligence Pro представляет собой рекуррентную нейронную сеть, позволяющую анализировать подозрительные транзакции в режиме реального времени. Она будет помогать банкам различать законные операции от мошеннических.

Президент бизнес-подразделения Mastercard по кибербезопасности и разведке Аджай Бхалла заявил, что новый алгоритм Mastercard обучается на объемной базе данных, содержащей информацию о примерно 125 млрд транзакциях. Все они ежегодно проходят через сеть компании. Благодаря этому технология способна повысить точность обнаружения мошенничества в среднем на 20 %, а в некоторых случаях этот показатель может возрасти до 300 %.

За последние пять лет Mastercard инвестировала более $ 7 млрд в развитие кибербезопасности и искусственного интеллекта. Тем самым в компании заявляют о защите финансовых операций и обеспечении безопасности для банков и их клиентов в глобальном масштабе.

Риски от генеративного искусственного интеллекта

Самый мощный GPT-4, который научился лгать руководству, когда научился торговать на бирже, может стать инструментом помощи людям в создании биологического оружия Хотя риск невелик, открытие является отправной точкой для продолжения исследований и профессионального обсуждения проблемы. Такие результаты исследований были обнаружены ведущими специалистами OpenAI.

Первые тесты, которые компания провела для понимания и предотвращения возможного «катастрофического» ущерба от своей технологии, показывают, что GPT-4 может представлять «как максимум» небольшой риск в разработке биологических угроз. В частности, в статье отмечается, что программа может облегчить задачу злоумышленникам по разработке биологического оружия, используя чат-боты для поиска информации о планировании атак.

Подписывайтесь на наш Telegram-канал, чтобы не пропустить важные новости. За новостями в режиме онлайн прямо в мессенджере следите на нашем Telegram-канале Информатор Live. Подписаться на канал в Viber можно здесь.

ЧИТАЙТЕ ТАКЖЕ:

Последние новости

Зеленский поручил очистить СБУ: все должны работать только на Украину

Гороскоп на 26 февраля: поток объятий и мечтаний

Зеленский провел разговор с Трампом: о чем говорили

Россияне ночью могут массированно ударить по Украине: подготовили ракеты и запустили Шахеды, есть угроза для Киева – мониторы

В Кремле пока отказываются от трехсторонней встречи на уровне лидеров: но Путин ждет Зеленского в Москве - Песков

В Германии задержан подозреваемый в убийстве Андрея Портнова

Это центр города, а тут понатыкали флажков: бывший боксер-киевлянин снял кринж-видео об Аллее памяти

Нардеп Власенко подал заявление в ДБР на НАБУ: назвал обыски в его кабинете провокациями

Использовали 3-тонную авиабомбу: враг взорвал дамбу в районе Константиновки - DeepState

Конец «цифрового преимущества» окупантов: Андрей Белецкий заявил о падении эффективности РФ на 40%

Компании РФ обошли санкции более чем на $8 млрд из-за британских островов: продали яхту Медведева, уголь по оккупации и самолеты Кадырова

Блокировка Telegram – вопрос привычки: нардеп Юрчишин оценил техническую возможность

Популярные

Зеленский поручил очистить СБУ: все должны работать только на Украину

Президент 25 февраля заслушал доклады от Службы безопасности, а также дал поручение Хмаре и Покладу по чисткам в органе.Гороскоп на 26 февраля: поток объятий и мечтаний

Хочется обниматься, готовить вкусную еду, создавать уют, слушать – астропрогноз на четверг для всех знаков Зодиака

Черт побери - зима возвращается: прогноз погоды на 26 февраля

Несмотря на незначительное похолодание, некоторые весенние погодные процессы уже запущены

Запрет Украине выступать на Евровидении – заявление одной из стран большой пятерки

На Евровидении 2026 года могут произойти существенные изменения: Украине и Израилю могут запретить участвовать в конкурсеРакетный удар РФ по Киеву сняли астронавты МКС: уникальное видео из космоса

На кадрах во время пролета МКС над Украиной видны вспышки взрывов в районе Трипольской ТЭС и вспышки от работы систем ПВОВоенный обозреватель

Архив об НЛО на 3,8 млн файлов исчез через час после приказа Трампа о его обнародовании

На севере Покровского направления все села под контролем ВСУ, серых зон нет – военный

Генпрокурор рассказал детали коррупционной схемы на строительстве укрытий для самолетов: самая крупная спецоперация за последние годы

Хорошие новости

Развернул украинский флаг на самой высокой точке Африки: днепрянин установил рекорд Гиннеса

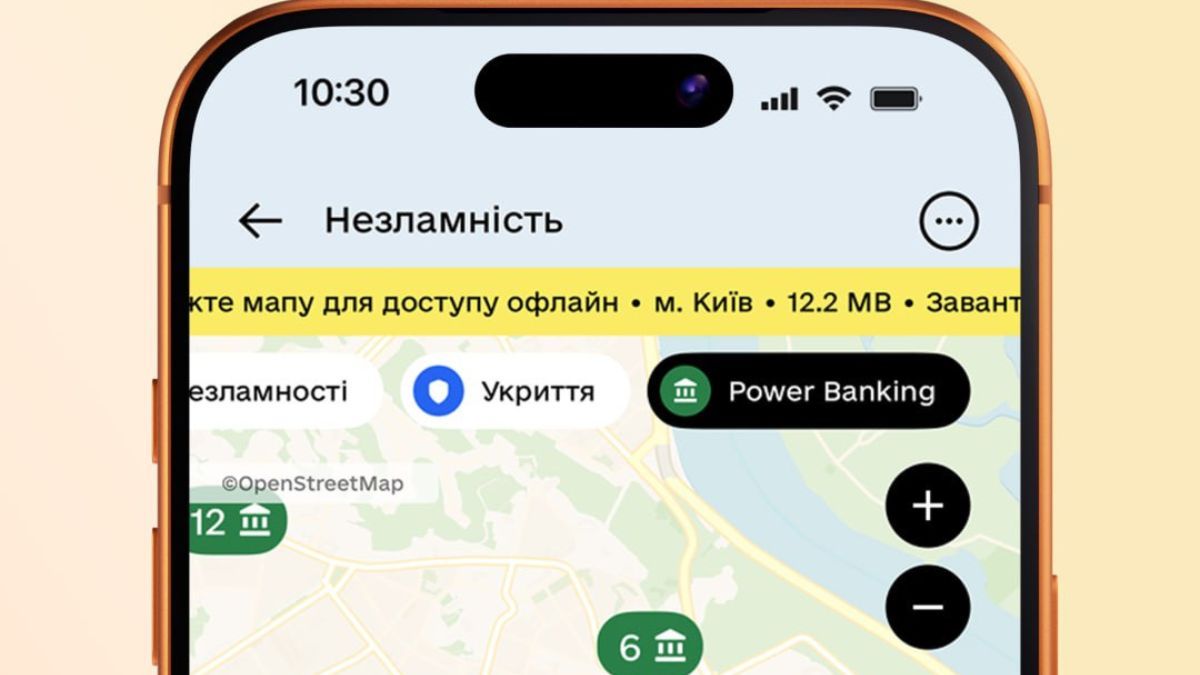

В Дія изменили систему поиска работающих, несмотря на блекаут банков.

Power Banking – это созданная по инициативе НБУ объединенная сеть отделений банков Украины, способных работать и предоставлять необходимые услуги клиентам даже во время длительного блекаутаВерховная Рада Украины приняла законопроект о социальной защите военных: в Минобороны раскрыли подробности

Закон формирует понятную и честную систему социальных гарантий для военнослужащих базовой службы – до, во время и после ее прохожденияМечем и волей: Укрпочта выпустила марку в честь годовщины войны

Марка издана 24 февраля 2026 года.

Ежемесячная выплата награжденным отличием "Крест боевых заслуг": объяснение Пенсионного фонда

Для назначения ежемесячной денежной выплаты лица, имеющие особые заслуги перед Родиной и члены их семей, подают заявление в любой территориальный орган Пенсионного фонда Украины, независимо от того находятся ли они на учете как получатели пенсии, или в электронной форме через веб портал электронных услуг Пенсионного фонда УкраиныПолитический обозреватель

Зеленский поручил очистить СБУ: все должны работать только на Украину

Нардеп Власенко подал заявление в ДБР на НАБУ: назвал обыски в его кабинете провокациями

Компании РФ обошли санкции более чем на $8 млрд из-за британских островов: продали яхту Медведева, уголь по оккупации и самолеты Кадырова

Новости столицы

Это центр города, а тут понатыкали флажков: бывший боксер-киевлянин снял кринж-видео об Аллее памяти

Стоп, приехали. В Киеве закроют мост Патона из-за ужасного состояния - источник

Киев возвращает электротранспорт на правобережье с 26 февраля

Киев получил от Гамбурга 20 генераторов разной мощности - Кличко

В Киевской области задержали торговцев трофейным оружием

Корреспондент проекта "Деньги"

Киевстар при покупке новой SIM-карты и активации предлагает только дорогие тарифы за 450–550 грн: жалоба и реакция компании

ПриватБанк без объяснений заблокировал все счета частного исполнителя, он требует 300 тысяч гривен за испорченную репутацию: что решил суд

ПриватБанк требует 64 939 гривен за кредит, которого «не было» — женщина подала встречный иск на 142 351 гривню: что решил суд

Экономика и финансы: последние новости

В Дія изменили систему поиска работающих, несмотря на блекаут банков.

Финмониторинг главная проблема: статистика жалоб на банки от НБУ

Верховная Рада Украины приняла законопроект о социальной защите военных: в Минобороны раскрыли подробности

Биодизель в Украине: сырьевой потенциал, региональные кластеры и перспективы рынка 2026

За минималку работают только больные на голову: глава Укрпочты попытался оправдаться

Экономический обозреватель Информатора

В Укрпочте ответили Информатору, используют ли они труд лошадей, ослов и лам

В Госпродпотребслужбе проводят проверку скандальной рекламы Укрпочты: ответ Информатору

Украинцы раскритиковали приложение 112 от МВД за 3 млн грн: Информатор знает, что можно улучшить

Любовь и купидоны в названиях украинских компаний: исследование YouControl

Дела 35 нардепов в Высшем антикоррупционном суде: декларирование, взятки, обогащение

Новости шоу-бизнеса

Запрет Украине выступать на Евровидении – заявление одной из стран большой пятерки

На Евровидении 2026 года могут произойти существенные изменения: Украине и Израилю могут запретить участвовать в конкурсе

Более месяца я планировала смерть: Leleka призналась – ее спас обычный камень

Певица рассказала, как преодолела сильную депрессию

Победительница Танців з зірками Руся Данилкина: Нога постоянно как в колючках, а на шоу приходилось пахать

Девушка впервые рассказала, через что прошла готовясь к шоу

Хочется поджать хвост и спрятаться под стол: Харчишин упомянул вокал Соловій, Fiїnka и Один в каное

Лидер группы Друга ріка откровенно раскритиковал отдельных украинских певиц.

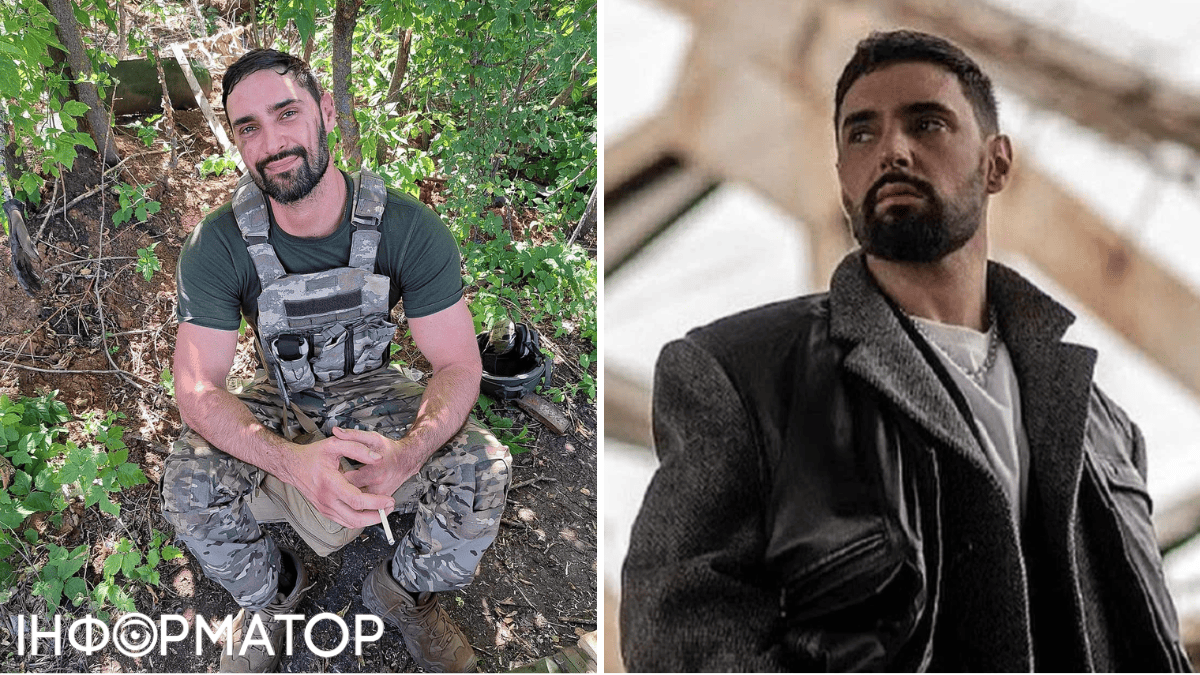

Пошел на войну, потому что опозорился: Виталий Козловский до сих пор извиняется за свою вину

Певец признался, что давняя ошибка его до сих пор преследуетКорреспондент проекта "Звезды"

Запрет Украине выступать на Евровидении – заявление одной из стран большой пятерки

Победительница Танців з зірками Руся Данилкина: Нога постоянно как в колючках, а на шоу приходилось пахать

Пошел на войну, потому что опозорился: Виталий Козловский до сих пор извиняется за свою вину

Про жизнь

Гороскоп на 26 февраля: поток объятий и мечтаний

Черт побери - зима возвращается: прогноз погоды на 26 февраля

Открывается портал возможностей, но нельзя ссориться: грядет самая судьбоносная дата – 26.02.2026

Обман длиной в жизнь: на самом деле желудку не нужны такие полезные привычки

Ревизор Ольга Фреймут не зря увлеклась миньоном

Черт побери - зима возвращается: прогноз погоды на 26 февраля

Позорная дыра в безопасности: инженер случайно захватил власть над семью тысячами умных пылесосов

Открывается портал возможностей, но нельзя ссориться: грядет самая судьбоносная дата – 26.02.2026

Новости Днепра