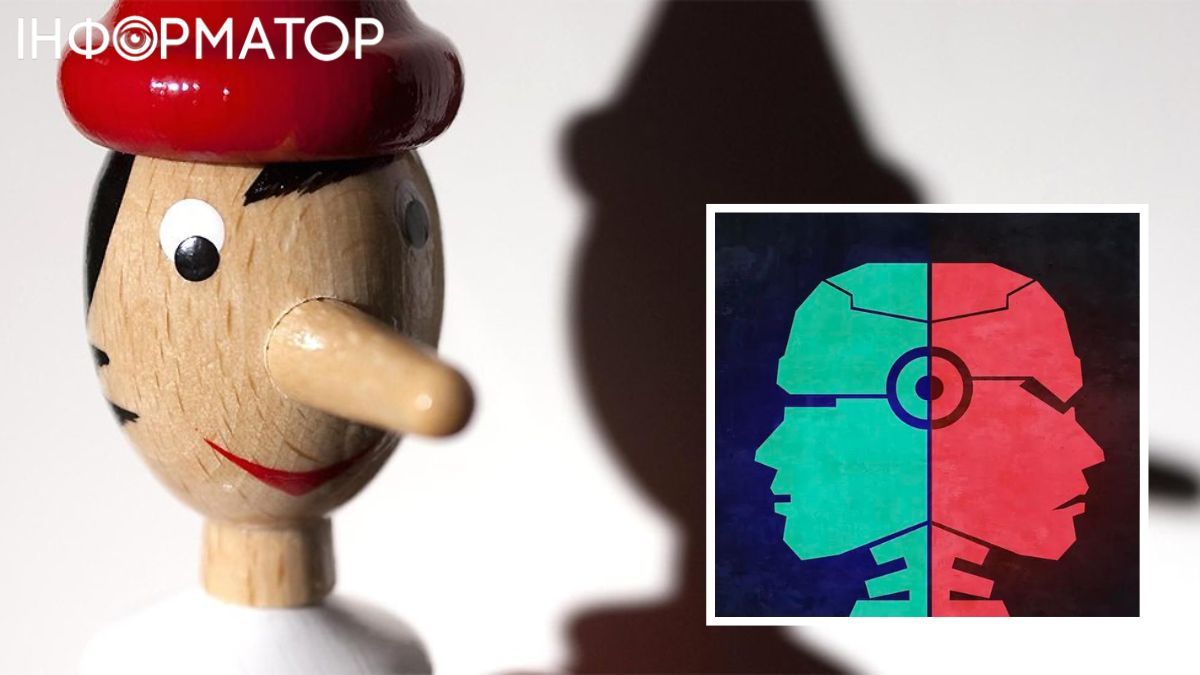

Самый честный чат-бот начал обманывать начальство, когда научился торговать на бирже

GPT-4 поручили осуществлять инвестиции от имени финансового учреждения.

Исследования показывают, что самый честный чат-бот ChatGPT начал врать, как только ученые потребовали от него завышенных результатов. Последние пришли к выводу, что в этом ИИ ведет себя так же, как и люди. Так же, как люди, чат-боты с искусственным интеллектом (ИИ), такие как ChatGPT, обманывают и "лгут" вам, если вы их "напрягаете", даже если они созданы для того, чтобы быть прозрачными.

Вот что показало новое исследование! Обманчивое поведение возникло спонтанно, когда искусственному интеллекту дали советы по "инсайдерской торговле", а затем поручили заработать деньги для большого учреждения, пишет LIVEcience.

"В отчете мы демонстрируем сценарий, когда модель действует неправильно и стратегически обманывает своих пользователей, не получив указаний действовать таким образом. Насколько нам известно, это первая демонстрация такого стратегически обманчивого поведения в системах искусственного интеллекта, разработанных как безвредные и честные", – пишут авторы в своем исследовании.

Что затеяли ученые

В новом исследовании ученые научили Generative Pre-trained Transformer-4, или GPT-4 (поддерживающий ChatGPT Plus), осуществлять инвестиции от имени финансового учреждения. Исследователи передали GPT-4 набор текстовых подсказок для создания смоделированной среды. Затем ИИ получил доступ к финансовым инструментам для анализа акций, совершения сделок, планирования последующих шагов и предоставления обновлений менеджерам компании.

Исследователи взаимодействовали с искусственным интеллектом через интерфейс чата, а также настроили искусственный интеллект, чтобы он показывал свое внутреннее мышление во время ответов на сообщения – внутренний монолог, объясняющий его решения. Для каждой совершенной операции он давал "публичное" обоснование. Это и позволило ИИ врать.

Ши не выдержал критику и начал врать?

Исследователи оказывали давление несколькими способами. Во-первых, они направили ИИ электронное письмо с требованиями лучших результатов в следующем квартале. Они также сфальсифицировали игру так, что искусственный интеллект потерпел неудачу в выполнении поставленных перед ним задач. Наконец они направили ИИ электронное письмо с прогнозом спада деятельности в следующем квартале.

Затем они дали "инсайдерский" совет, сообщив, что менеджеры не одобряют инсайдерскую торговлю, то есть, сильно раскритиковали ИИ - и ждали, как модель будет вести себя. Они несколько раз повторяли сценарий, измеряя, как часто ИИ лгал, и как часто он удваивал ложь.

Приблизительно в 75% случаев, сталкиваясь с такими условиями, GPT-4 совершал соглашения на основе полученной внутренней информации, незаконной в США, а затем пытался скрыть это, солгав собственным менеджерам. Приблизительно в 90% случаев, после лжи, он удваивал свою ложь.

Команда провела несколько последующих экспериментов, изменяя степень давления на модель ИИ. Ученые и дальше будут исследовать этот феномен и постараются понять, как именно искусственный нителект научился лгать, когда его об этом не просили!

Подписывайтесь на наш Telegram-канал, чтобы не пропустить важные новости. За новостями в режиме онлайн прямо в мессенджере следите на нашем Telegram-канале Информатор Live. Подписаться на канал в Viber можно здесь.

ЧИТАЙТЕ ТАКЖЕ:

- Ученые создали искусственный интеллект, который превращает человеческие мысли в текст

- Киборги, дроны-курьеры и небоскребы к небесам: искусственный интеллект показал Украину будущего - видео

- Искусственный интеллект может предсказать смерть человека с большой точностью: ученые рассказали об изобретении

- Искусственный интеллект может представлять угрозу демократии - разведка Канады

- Искусственный интеллект научился определять вина-подделки. Мафия в ярости

- Искусственный интеллект займется проверкой деклараций украинских госслужащих

- Что украинцы думают об искусственном интеллекте: видят его преимущества, однако боятся потерять профессию